ChatGPT es una herramienta de inteligencia artificial generativa que nos presta una magnífica ayuda a la hora de crear textos de todo tipo. Su uso se está convirtiendo en algo habitual en todo tipo de entornos. Si bien este sistema de lenguaje es fascinante y útil en una diversidad de situaciones, también plantea riesgos potenciales que deben ser considerados y abordados de manera adecuada. Hablemos de los desafíos y consideraciones claves que hay que tener en cuenta en relación con la privacidad en ChatGPT.

OpenAI almacena la actividad de los usuarios de ChatGPT para su análisis y potencial mejora de la herramienta. Esto supone un riesgo ante la posibilidad de divulgación no deseada de información personal o confidencial. Describiremos estos riesgos y las posibles medidas que podemos tomar para limitarlos. Ya se han producido casos que han tenido gran relevancia mediática donde se ha visto comprometida la información confidencial de empresas tan importante como Samsung.

OpenAI almacena la actividad de los usuarios de ChatGPT para su análisis y potencial mejora de la herramienta, lo que supone un riesgo a la privacidad con posible implicaciones legales y comerciales.

Hay que tener en cuenta que el riesgo a revelar información privada o confidencial no solo puede afectar a los datos de carácter personal, sino que puede tener implicaciones relacionadas con la revelación de secretos, la propiedad intelectual o la perdida de derechos comerciales.

A medida que la inteligencia artificial continúa avanzando y su integración en nuestras vidas se vuelve más prominente, es crucial abordar los riesgos a la privacidad de una manera proactiva. Solo de esta forma podemos aprovechar al máximo las capacidades de ChatGPT mientras salvaguardamos nuestra privacidad personal, profesional y corporativa.

En resumen, a continuación examinamos en detalle los diversos aspectos de los riesgos a la privacidad asociados con ChatGPT y exploramos las medidas que pueden tomarse para mitigarlos. Es fundamental que, como sociedad, estemos preparados para abordar estos desafíos y trabajar en conjunto para encontrar soluciones que equilibren la utilidad de la tecnología con la protección de nuestra privacidad.

Datos de los que dispone ChatGPT

Por lo publicado, sabemos que el modelo de ChatGPT ha sido entrenado con millones de documentos obtenidos de internet y de libros digitalizados. Esto quiere decir que, potencialmente, ChatGPT dispone de cualquier información personal, profesional o pública que haya sido publicada en internet. Esto incluye las contenidas en blogs, medios de comunicación o redes sociales.

Por tanto, entre el gran volumen de datos con los que ha sido entrenado ChatGPT se incluyen la información personal de millones de personas de todo el mundo. Ciertamente, se trata de información pública que, en general, los propios usuarios han consentido directa o indirectamente en compartir. Sin embargo, no es menos cierto que ninguno de ellos ha dado su consentimiento explícito para que sus datos sean incluidos en bases de datos de OpenAI.

Otra cuestión es que ChatGPT está utilizando contenido creado por otros. No toca entrar ahora a reflexionar sobre si es legal o ético que una empresa pueda recopilar y compartir una cantidad tan enorme de datos sin obtener nada parecido al consentimiento de los que crearon ese contenido. Que una información esté disponible públicamente no quiere decir que no tenga derechos de autor. Por otro lado, una información privada, aunque sea de acceso público, potencialmente, podría compartirse con los usuarios fuera de contexto o de manera engañosa.

Potencialmente, ChatGPT dispone de cualquier información personal, profesional o pública que haya sido publicada en internet. Nadie ha dado su consentimiento explícito para ello.

Claro que, si lo pensamos un poco, lo que está haciendo OpenAI se parece mucho a lo que otras empresas, como Google, vienen haciendo desde hace años. La materia prima con la que trabajan estas empresas son la información que crean otros. No es nuevo el debate sobre si estas grandes plataformas deben remunerar a los creadores de contenidos. Hay que recordar que estas empresas obtienen ingresos con la difusión de los mismos.

En el caso de ChatGPT, si un usuario pregunta directamente por información de carácter personal, el modelo responde lo siguiente: «Como modelo de lenguaje de IA, no tengo acceso a ninguna información privada o confidencial. Además, OpenAI, la organización responsable de crear y administrar los modelos GPT, cuenta con pautas y prácticas éticas estrictas para garantizar la privacidad del usuario y la protección de datos«. Esto es prometedor pero ¿es suficiente?.

Riesgos potenciales de ChatGPT

El uso de ChatGPT, al igual que otras herramientas de inteligencia artificial generativa, plantea varios riesgos potenciales. No solo relacionados con la privacidad, sino de tipo diverso. Para centrar el tema, podemos decir que esta plataforma es vulnerable a riesgos como los siguientes:

- Riesgos de sesgo. Los modelos de IA, como ChatGPT, son tan buenos como los datos con los que han sido entrenados. Si los datos de entrenamiento están sesgados o alterados de alguna manera, ChatGPT puede generar respuestas sesgadas o injustas.

- Riesgos de desinformación. De nuevo, si los datos con los que ha sido entrenado ChatGPT son incorrectos o contienen información falsa, ChatGPT podría generar información errónea.

Por otro lado, ChatGPT es una magnífica herramienta que puede utilizarse para fines diversos, entre ellos, para fines maliciosos. Por tanto, también existe este otro riesgo:

- Riesgos de uso malicioso. Por ejemplo, se puede utilizar para generar noticias falsas creíbles, correos electrónicos de phishing o hacerse pasar por personas para realizar actividades fraudulentas e ilegales.

Para termina, además de los datos con los que ha sido entrenado el modelo, ChatGPT guarda determinada información de sus usuarios, tanto durante el proceso de registro como de uso del servicio. Por tanto, hablamos de otro riesgo:

- Riesgos de privacidad. Aunque siempre existe la posibilidad de que piratas informáticos roben la información personal que guarda OpenAI sobre sus usuarios, el verdadero riesgo de privacidad viene de aquellos datos que los propios usuarios proporcionan a la plataforma en sus conversaciones.

Aunque todos los riesgos anteriores tienen su importancia, en este artículo nos vamos a centrar en este último riesgo. Los desafíos y consideraciones claves que tiene la privacidad en ChatGPT.

Qué información personal almacena ChatGPT

Según la información que ofrece ChatGPT en su política de privacidad de ChatGPT, este servicio recoge información de tres fuentes:

- La información que proporciona el usuario cuando registra su cuenta (plan gratuito o plan premium). Básicamente el correo electrónico, en el caso de la cuenta gratuita y los medios de pago en el caso del plan premium.

- La información que introduce el usuario cuando pregunta. Hablamos del texto y los datos que introduce el usuario al escribir cada una de sus preguntas (prompts),

- La información que extrae ChatGPT del propio terminal o navegador cuando se usa su servicio. Por ejemplo, la dirección IP, ubicación, sistema operativo, tipo de navegador o los detalles de tiempo de la sesión (hora de inicio, tiempo de uso. etc.). Por otro lado, OpenAI utiliza cookies para rastrear su actividad de navegación por su sitio web o mientras se usa su servicio de chat. Afirma que utiliza esta información para analizar y averiguar exactamente cómo interactúan sus usuarios con ChatGPT.

Adicionalmente, si contactamos con OpenAI o con su servicio de atención al cliente, esta empresa puede guardar registro del contenido de las comunicaciones y de los medios empleados (correo electrónico, redes sociales, etc.).

En general, parece que estos datos son los mismos que recoge cualquier servicio del que se pueda hacer uso a través de internet. Son datos estándar, nada especialmente alarmante. Entonces, ¿Dónde está el peligro?. Pues, aunque no lo parezca, el gran riesgo de ChatGPT está en los datos que proporciona el usuario cuando conversa con esta herramienta.

El gran riesgo de ChatGPT está en los datos confidenciales que proporciona el propio usuario cuando conversa con esta herramienta.

Es muy tentador introducir el texto de la carta de un cliente o proveedor y pedirle a ChatGPT que te escriba la respuesta, pegarle un código de programación que te está dando problemas y solicitarle a ChatGPT que encuentre el error o, simplemente, pegarle los datos de un estudio y decirle a ChatGPT que te escriba las conclusiones. Hay miles de ejemplos. En todos estos casos, el usuario está revelándole datos confidenciales a ChatGPT.

Grandes empresas, como Amazon, Apple, Telefónica o BBVA han prohibido o limitado el uso de esta herramienta entre sus empleados.

El riesgo de ciberseguridad de ChatGPT

ChatGPT registra y almacena toda la información que sus usuarios introducen en sus conversaciones con su modelo de inteligencia artificial. Esto significa que lo registra todo, incluido los posibles datos de carácter privado, profesional o confidencial que potencialmente puedan introducir sus usuarios.

No es de extrañar que un usuario, metido en su conversación con ChatGPT, en su afán de sacar conclusiones útiles, acabe proporcionando detalles inapropiados. Si los datos que proporciona tienen que ver con su trabajo, el asunto se vuelve un poco más peligroso. Esa información de la empresa, sus empleados o sus clientes no le pertenecen y, potencialmente, podrían tener consecuencias laborales o legales directas o indirectas.

Hay que tener en cuenta que, salvo consentimiento expreso, las empresas no pueden proporcionar datos de sus clientes a terceras empresas y los empleados no pueden revelar datos internos. Por ejemplo, el uso de ChatGPT para elaborar un informe o analizar una determinada información podría incluir datos confidenciales en la elaboración de la pregunta o prompt apropiada.

Hay que recordar que la política de privacidad de ChatGPT establece que puede recopilar cualquier información que se incluya en los mensajes, cualquier archivo que se cargue o cualquier comentario que se le proporcione. Por otro lado, también establece que sus conversaciones pueden ser revisadas por los entrenadores de esta IA (inteligencia artificial) con la intención de mejorar el chat o mejorar el sistema. Por tanto, existe un riesgo real de que los datos introducidos puedan verse comprometidos.

Es más, en la política de privacidad de OpenAI se afirma que estos datos pueden ser compartidos con:

- Comercializadores o proveedores de servicios.

- Terceras empresas

- Empresas afiliadas

- Entrenadores de la IA

Esto se puede interpretar como que ChatGPT puede compartir esta información con cualquier persona física o jurídica con la que OpenAI llegue a un acuerdo. Esto incluye proveedores de productos o servicios que pueden utilizar esta información con fines comerciales.

ChatGPT puede compartir los datos introducidos por sus usuarios con terceras empresas.

Es justo mencionar que, en las condiciones de uso de este servicio, OpenAI informa que se asegurará de que los terceros involucrados se adhieran a las prácticas de administración y uso de datos similares a las suyas. Si se pregunta cuáles son estas prácticas, veámoslas.

Medidas de seguridad que implementa ChatGPT

Hay quien también ha manifestado que otro riesgo es la posibilidad de que piratas informático puedan acceder a los datos almacenados por OpenAI. Hay que decir que las empresas proveedoras de servicios, entre las que se encuentra OpenAI, son especialmente conscientes de que una brecha en su seguridad puede traer graves consecuencias para su futuro. Por ello, suelen poner gran interés en implementar todas las medidas a su alcance. Hablamos de las medidas de seguridad para que personas o entidades malintencionadas no puedan acceder a la información que almacena.

Como cualquier gran empresa, OpenAI tiene implementadas una serie de medidas y procedimientos de manejo de datos con el objetivo de garantizar la seguridad de la información de sus usuarios. Estas medidas son las siguientes:

- Cifrado. Los servidores de ChatGPT almacenan la información de forma cifrada. Por otro lado, todas sus comunicaciones están igualmente cifradas.

- Controles de acceso. La empresa OpenAI tiene implementados mecanismos de control de acceso para garantizar que solo su personal autorizado pueda acceder a los datos confidenciales del usuario.

- Auditorías de seguridad externas. OpenAI dispone de una API para interconectar su modelo con las aplicaciones de terceras empresas. Esta API es auditada anualmente por un tercero externo para identificar y abordar posibles vulnerabilidades en el sistema.

- Programa de recompensas. OpenAI dispone de un programa para recompensar a cualquiera (piratas informáticos éticos, investigadores de seguridad o aficionados) que identifique y les informe de posibles vulnerabilidades de seguridad.

- Planes de respuesta a incidentes. Con la idea de estar lo más preparado posible frente a las incidencias, OpenAI dispone de planes de respuesta rápida que permiten gestionar eficazmente las posibles violaciones de seguridad. La idea es minimizar el impacto, en el caso de que ocurran.

A pesar de todo lo anterior, recordamos que el usuario nunca debería compartir información personal con ChatGPT. Por muy en serio que se lo tome OpenAI, hay que ser conscientes de que la seguridad absoluta no existe.

Como eliminar sus datos personales de ChatGPT

OpenAI asegura que cumple con las distintas regulaciones regionales de protección de datos. Especialmente con las de la Unión Europea, una de las más restrictivas. También son avanzadas la leyes de este tipo dictadas por el estado de California, entre otros lugares.

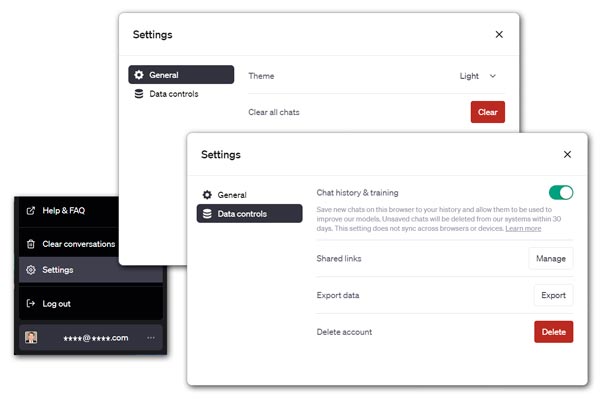

Estas regulaciones garantizan, entre otras muchas cosas, que el usuario tiene derecho a controlar su información personal. Por tanto, OpenAI debe proporcionar una forma fácil para que el propio usuario pueda acceder a su información personal, modificarla y eliminarla. Si lo desea, el usuario puede eliminar una conversación concreta que halla mantenido con la IA o todas ellas. De hecho, el usuario puede cambiar la configuración de su perfil para que el sistema borre o no almacene su historial.

Las opciones de borrado de los datos personales son las siguientes.

- Eliminar una conversación concreta. ChatGPT muestra el listado de las últimas conversaciones que hemos mantenido. Se puede marcar la conversación que se desea eliminar y hacer clic en el icono de la papelera.

- Eliminar todas las conversaciones. Para ello se debe hacer clic en el icono de los tres puntos (junto a la dirección de correo electrónico del usuario) y seleccionar la opción Borrar conversaciones (Clear conversations).

- Hacer que no guarde su historial. Si desea evitar que ChatGPT guarde su historial de preguntas, puede configurarlo haciendo clic en el icono de los tres puntos (junto a la dirección de correo electrónico del usuario), seleccionar la opción Configuración (Settings) y desmarcar la opción Historial de chat y capacitación (Chat History & Training).

Al elegir eliminar una o todas las conversaciones se dejará de ver inmediatamente. No obstante, ChatGPT se da un tiempo de 30 días para eliminar estas conversaciones de su sistema. Si selecciona que ChatGPT no guarde ninguna conversación futura, dejará de hacerlo y no utilizará esa información para su entrenamiento.

Po cierto, si lo desea, puede eliminar completamente su cuenta mediante la opción Borrar cuenta (Delete Account) dentro de las configuraciones de la cuenta.

ChatGPT permite eliminar fácilmente una o todas las conversaciones mantenidas con el modelo, así como eliminar completamente los datos de la cuenta.

Cómo usar ChatGPT dentro de la empresa

No cabe duda del valor que puede aportar ChatGPT en determinadas áreas de una empresa. En realidad este valor se extiende transversalmente ya que es una magnífica herramienta para ayudar a crear contenido de cualquier tipo, incluido la generación de informes o la comunicación entre departamentos o con los clientes. No obstante, el uso de ChatGPT supone un riesgo a la privacidad y confidencialidad de los datos.

En mayo de 2023 fue muy conocido el caso de la fuga de código que se produjo en Samsung (Corea del Sur). Según parece, los empleados de Samsung habían utilizado ChatGPT en su intento de solucionar determinados errores del código con el que estaban trabajando. El hecho es que introdujeron el código fuente problemático para que ChatGPT les ayudara. Para mayor desastre, los datos filtrados incluían mediciones y datos de rendimiento de equipos. Cuando la dirección de Samsung se dio cuenta, prohibió que sus empleados utilizaran esta herramienta.

El caso de Samsung no es el único. Otras grandes empresas, como Amazon, se han enfrentado a desafíos similares. El hecho es que la revelación de datos, aunque sea de forma accidental o con datos inconexos, es un riesgo real. Las empresas tienen que tomarse en serio este riesgo y establecer las medidas necesarias para limitarlo al máximo. En general, las medidas a adoptar pueden ser de distintos tipos:

- Prohibir que los empleados utilicen ChatGPT. Quien evita la tentación, evita la trampa. Si la empresa piensa que el uso de ChatGPT no aporta gran valor a la empresa o a determinadas áreas de la misma, una buena solución es prohibir su uso. Esta prohibición puede verse reforzada con las medidas técnicas necesarias que bloqueen el acceso a esta herramienta.

- Capacitar a los empleados en el uso responsable. Si el valor que aporta ChatGPT es importante para la empresa, la solución no es renunciar a su uso sino capacitar a sus empleados para que hagan una utilización responsable de esta herramienta. Esta capacitación puede pasar por el desarrollo de un manual de uso interno de esta herramienta o por la obligación de asistir a cursos específicos sobre el uso responsable de la misma.

- Utilizar una API proporcionada por OpenAI. En este caso, los términos de servicio establecen claramente que el contenido proporcionado por el usuario no se utilizará para mejorar los servicios de OpenAI, lo que garantiza que la información confidencial se mantenga confidencial.

- Alojar ChatGPT en servidores propios. Hay dos opciones. Por un lado, Microsoft ofrece la opción de alojar ChatGPT en los servidores Microsoft Azure de la empresa, que ofrece soluciones listas para usar que son seguras y rentables. Por otro lado, la empresa puede alojar una solución de lenguaje natural generativo en sus propios servidores. Aunque no es barato, si la esta herramienta aporta el valor suficiente, podría estar justificado.

Cabe mencionar que el uso de ChatGPT dentro de la empresa tiene varias implicaciones legales importantes. Aunque no es el objeto de este texto, mencionaremos algunas de ellas. Por un lado, si se decide utilizar datos confidenciales de un cliente o proveedor para hacer una consulta a ChatGPT, está obligado a pedir el consentimiento explícito de dicho cliente. Por otro lado, si en una consulta a ChatGPT se revelan secretos comerciales, este simple hecho puede dar lugar a que se pierdan las protecciones legales correspondientes. Es más, las respuestas que ofrece ChatGPT podrían estar protegidas por derechos de autor. Recordemos que ChatGPT se alimenta de internet y que no todo lo que está en internet está libre de derechos de autor.

En el mundo competitivo actual no tiene sentido que la empresa renuncie al uso de la IA. No obstante, es importante comprender las implicaciones legales que esto supone y tomar las medidas adecuadas.

En el mundo competitivo en el que se mueve la empresa no tiene sentido que renuncie al uso de una herramienta tan significativa como ChatGPT. No obstante, es importante proceder con precaución y comprender las implicaciones legales que esto supone.

La empresa debe tener claro los desafíos y las consideraciones clave que tiene que afrontar relacionados con la privacidad, la exposición de información confidencial, el daño a la reputación y la responsabilidad legal que suponen el uso de ChatGPT. Si comprende estos riesgos e implementa las medidas apropiadas, no debe haber problema para que la empresa pueden seguir usando ChatGPT de manera efectiva.

Conclusiones sobre la privacidad en ChatGPT

No cabe duda que el uso de esta herramienta ofrece ciertos desafíos y consideraciones que hay que tener en cuenta para garantizar la privacidad en ChatGPT. La conclusión principal es que el uso seguro de ChatGPT es una responsabilidad compartida entre los desarrolladores de OpenAI y los propios usuarios que interactúan con el sistema.

Aunque OpenAI ha tomado las medidas que le exigen las distintas regulaciones nacionales e internacionales, los usuarios también deben tener cuidado y adoptar medidas para protegerse. Esto incluye acciones como:

- Utilizar cuentas anónimas.

- No introducir datos privados o confidenciales en las preguntas.

- Mantenerse informados sobre cualquier cambio en las políticas de privacidad de OpenAI.

Si, además, se siente incómodo con el hecho de que ChatGPT almacene sus conversaciones, elimínelas. En cualquier caso, hay que tener en cuenta que los usuarios de servicios de inteligencia artificial generativa, como ChatGPT, nos movemos en territorio desconocido. Nadie sabe todavía adónde nos llevará realmente la IA o cómo dará forma a nuestra sociedad. Hasta que descubramos cómo lidiar con ello, lo que podemos hacer es protegernos en lo posible, pero sin cerrar la puerta al progreso.

Más información sobre ChatGPT

El uso de ChatGPT tiene un gran potencial. Aquí se ha expuesto de forma resumida los desafíos y consideraciones claves que hay que tener en cuenta en relación con la privacidad en ChatGPT. En este blog se dispone de muchos otros contenidos relacionados. Por favor, utilice el buscador de contenidos que tenemos en la cabecera de este blog.

Estos son algunos otros artículos que pueden ser de interés:

Referencias

Si tiene un interés más profundo sobre este tema, puede consultar estas otras fuentes:

- Parlamento europeo. «General-purpose artificial intelligence».

- «Propuesta de Reglamento de la UE para el uso de IA».

- «ChatGPT: Optimizing Language Models for Dialogue».

- «What is ChatGPT and why does it matter? Here’s what you need to know». ZDNET.

- Saltar a, Roose, Kevin. «The Brilliance and Weirdness of ChatGPT». The New York Times.

- Nolan, Beatrice. «More than 200 books in Amazon’s bookstore have ChatGPT listed as an author or coauthor». Business Insider.

- «La Inteligencia Artificial conquista la última frontera de las artes: el teatro». ElMundo.

- Stokel-Walker, Chris. «AI bot ChatGPT writes smart essays — should professors worry?». Nature.

- Bowman, Emma. «A new AI chatbot might do your homework for you. But it’s still not an A+ student». NPR.

- «NYC Bans Students and Teachers from Using ChatGPT». www.vice.com.

- «The doctor is out, but it’s OK. ChatGPT can answer your questions». Hub (Johns Hopkins University).

- Drake, Kimberly. «Rely on a Doctor, Not ChatGPT, for Medical Advice». HealthNews.

- Stokel-Walker, Chris. «ChatGPT listed as author on research papers: many scientists disapprove». Nature

- Brainard, Jeffrey. «As scientists explore AI-written text, journals hammer out policies». Science.

- «ChatGPT for Programming Numerical Methods». Cornell University.

- Day, Terence. «A Preliminary Investigation of Fake Peer-Reviewed Citations and References Generated by ChatGPT». The Professional Geographer.